Cosa sono i Big Data? A cosa servono? Queste due domande sono più frequenti di quanto non si pensi. Si dice spesso che i dati sono “il nuovo petrolio”, ma non si ha idea di quale volume se ne produca ogni giorno e spesso neppure i vantaggi che offra la loro gestione e analisi. Basti pensare che di dati ne vengono generati con un flusso così grande che tutte le informazioni accumulate nel corso degli ultimi due anni ha superato l’ordine dei Zettabyte (1021 byte), segnando un record per l’umana civiltà. Già nel 2010 il report How Much Information metteva in luce la possibilità che ognuno di noi generasse mediamente 12 gigabyte di dati ogni giorno. Pensiamo dieci anni dopo quanto possono essere aumentati, con l’utilizzo di sempre nuovi device… Secondo IDC, la “datasfera” globale crescerà dai 23 zettabyte del 2017 ai 175 del 2025. Inoltre, ogni anno la dimensione dei dati raddoppia.

Tutti i giorni enormi volumi di “seganli” vengono raccolti sotto forma di dati: da sensori, sul traffico, di telemedicina, dal settore energetico, dati meteo e molto altro ancora. Da qui nasce quella che è da considerare a tutti gli effetti la rivoluzione Big Data e, in generale, il termine si riferisce proprio a cosa si può fare con tutta questa quantità di informazioni, ossia agli algoritmi capaci di trattare così tante variabili in poco tempo e con poche risorse computazionali.

Cosa sono i big data: una definizione

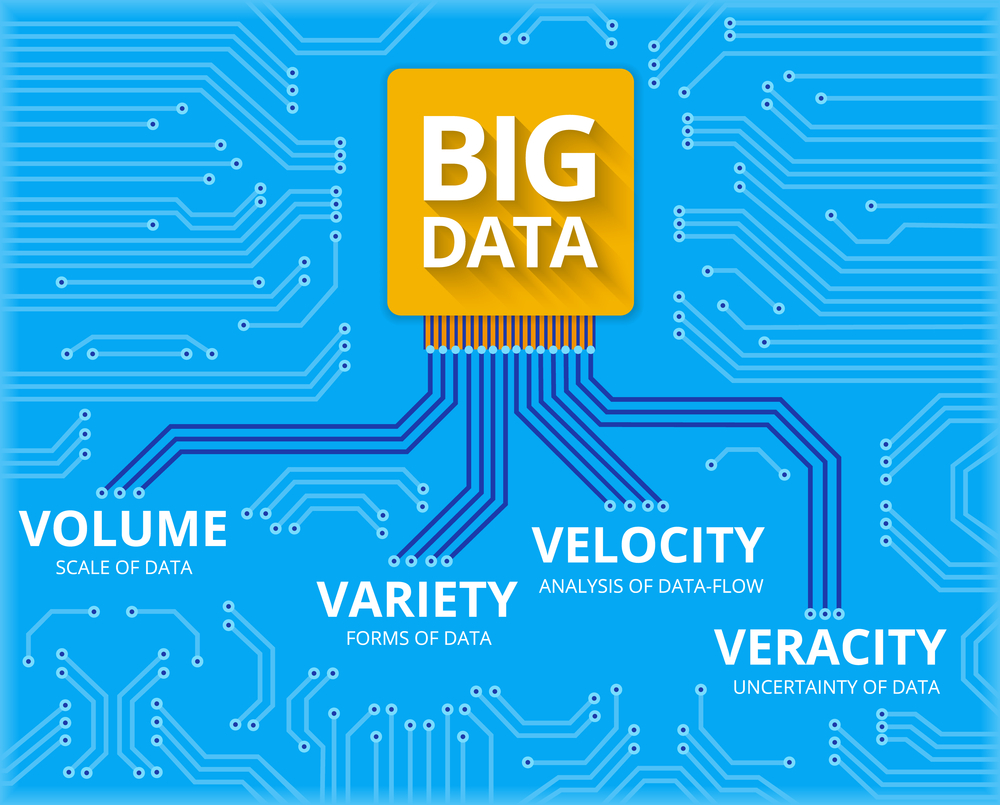

Con Big Data, secondo la definizione di Gartner, ci si riferisce a risorse informative caratterizzate da enorme volume, elevata velocità di produzione e grande varietà tali da richiedere tecnologie e metodi analitici specifici per l’estrazione di valore o conoscenza.

Per comprendere la loro importanza e l’ordine di grandezza occorre considerare che fino a qualche anno fa, uno scienziato per analizzare una mole di dati che oggi definiremmo Small o Medium Data ci avrebbe messo molto tempo e si sarebbe servito di computer mainframe da oltre 2 milioni di dollari. Oggi, con un semplice algoritmo, quelle stesse informazioni possono essere elaborate nel giro di poche ore, magari sfruttando un semplice laptop per accedere alla piattaforma di analisi. Questa è la rivoluzione Big Data.

Per la IATE (Interactive Terminology for Europe) con questo termine si definiscono vari aspetti come big data processing, big data analytics, big data technology, big data computing ecc.

Le 5 V dei big data (e le altre)

Il concetto di big data ha acquisito uno slancio a partire dal 2001, quando l’analista di Gartner Doug Laney – oggi Data & Analytics Innovation Fellow alla West Monroe – descrisse con un modello semplice e sintetico lo scenario in cui stavano prendendo forma i Big Data. Nacque così il modello delle 3V: Volume, Velocità e Varietà. Oggi il paradigma di Laney è stato arricchito da altre due V, ovvero le variabili di Veridicità e Variabilità e per questo si parla di 5V.

Con volume si intendono elevate moli di dati (più di 50 TB) o in forte crescita ( maggiore del 50% annuo); per velocità s’intende invece la rapidità di generazione e acquisizione dei dati. La varietà attiene alla eterogeneità dei dati per fonte e formato. Qualità e affidabilità dei dati costituiscono la base per la veridicità dei Big Data. Per quanto riguarda infine la loro variabilità, si intende la mutevolezza del significato di un dato a seconda del contesto.

Per completare il paradigma dei Big Data andrebbero considerate altre V, come hanno avuto modo di riportare Ripon Patgiri e Arif Ahmed nell’articolo Big Data: The V’s of the Game Changer Paradigm: Veridicità, Valore, Validità, Variabilità, Volatilità, Visibilità.

A cosa servono e come vengono utilizzati

L’utilizzo dei Big Data ha un enorme potenziale nella sfera professionale pubblica e privata. In un report di McKinsey sui Big Data si forniva un utile metro di comprensione: se il settore sanitario statunitense li utilizzasse in modo efficace per aumentare l’efficienza e la qualità, potrebbe creare più di 300 miliardi di dollari di valore ogni anno. Due terzi di questi sarebbero sotto forma di riduzione della spesa sanitaria statunitense di circa l’8%. Nelle economie sviluppate dell’Europa, gli amministratori governativi potrebbero risparmiare qualcosa come 149 miliardi di dollari in miglioramenti dell’efficienza operativa solo utilizzando Big Data, senza contare l’utilizzo di grandi dati per ridurre le frodi e gli errori e aumentare la riscossione delle entrate fiscali.

L’importanza dei big data non ruota intorno alla loro quantità, ma al loro utilizzo. Per esempio, è possibile accedere ai dati provenienti da qualsiasi fonte, analizzarli e trovare risposte che consentano di ridurre i costi, accorciando le tempistiche, sviluppando nuovi prodotti e ottimizzando le offerte, oltre a permettere di prendere decisioni più mirate.

Combinando big data e analytics, infatti, si possono:

- determinare le cause di guasti, problemi e difetti in tempo quasi reale;

- generare coupon presso i punti vendita in base alle abitudini d’acquisto dei clienti;

- ricalcolare interi rischi di portafoglio in pochi minuti.

A ciò si aggiunge la possibilità di rilevare un comportamento fraudolento prima che colpisca l’azienda.

Gli obiettivi aziendali possibili da raggiungere grazie ai Big Data sono molteplici. Le imprese che hanno già messo in atto progetti di data analysis e data management lo hanno fatto per:

- migliorare l’engagement con il cliente;

- incrementare le vendite;

- ridurre il time to market;

- ampliare l’offerta di nuovi prodotti e servizi;

- ottimizzare l’offerta attuale al fine di aumentare i margini;

- ridurre i costi;

- identificare nuovi mercati.

Detto dell’importanza dei Big Data e a cosa possono servire, resta da comprendere come utilizzarli.

Innazitutto, occorre preparare i big data all’analisi, che significa accedervi, profilarli, ripulirli e trasformarli. Poi si passa alla Data Analysis, costituita da quattro grandi tipologie.

- La prima è la Descriptive Analytics, ovvero l’analisi descrittiva, il processo di analisi dei dati storici che aiutano a comprendere meglio i cambiamenti avvenuti in un’azienda.

- C’è poi la Predictive Analytics (Analisi Predittiva) finalizzata a fare previsioni sui risultati futuri basati su dati storici e tecniche di analisi.

- Terza tipologia è quella delle Prescriptive Analytics, ovvero strumenti di analisi dei dati finalizzata a prendere decisioni.

- Infine, ci sono le Automated Analytics, che riguarda la capacità analitica di rilevare automaticamente le anomalie, i modelli e le tendenze rilevanti e di fornire approfondimenti agli utenti aziendali in tempo reale.

Le Predictive Analytics (Analisi Predittive) sono basata su soluzioni che permettono di effettuare l’analisi dei dati al fine di disegnare scenari di sviluppo nel futuro

Il valore dei big data in azienda

Veniamo ora a considerare quale impatto abbiano i Big Data per il business. La loro importanza sta nei numeri. Il mercato degli Analytics si attesta su un valore complessivo di 1.393 miliardi di euro, come rileva l’Osservatorio Big Data Analytics & Business Intelligence del Politecnico di Milano, sottolineando inoltre come l’importanza dei Big Data vada oltre la dimensione puramente numerica.

L’analisi dei dati offre un potenziale enorme per le aziende ed i benefici da cogliere sono innumerevoli. Se in passato poteva essere considerato accettabile, oggi non approcciare i Big Data Analytics equivale a perdere opportunità, in casi estremi equivale ad essere esclusi da nuovi mercati o addirittura da quelli in cui già si opera.

Secondo un’indagine dell’Osservatorio Big Data Analytics & Business Intelligence, il mercato italiano dei Big Data Analytics ha raggiunto nel 2019 un valore di 1,7 miliardi di euro, in crescita del 23% rispetto all’anno precedente, oltre il doppio rispetto al 2015 (790 milioni), da cui è cresciuto con un tasso medio annuo del 21,3%.

La gestione dei Big Data si conferma ai vertici tra le priorità di investimento di CIO e Innovation Manager italiani. L’interesse verso i Big Data Analytics e le scelte d’investimento sono differenti a seconda della dimensione delle organizzazioni prese in esame. Con riferimento alle grandi aziende, sono due le tendenze prevalenti. Da un lato le imprese più innovative, che hanno già avviato progetti, stanno raccogliendo i frutti dei primi investimenti e spingono ora su tecnologie sempre più evolute. Dall’altro, le aziende “ritardatarie” corrono ai ripari, rinnovando processi e architetture in ottica Big Data. Le PMI procedono piuttosto a rilento, ma mostrano comunque di crederci: nel 62% dei casi le piccole e medie imprese hanno fatto investimenti nel 2019, concentrati soprattutto nell’integrazione dei dati interni (80%), nella formazione di base sull’analisi dei dati per risorse già presenti in azienda (66%), nell’integrazione di dati da fonti esterne (57%) e nello sviluppo di progetti di analisi predittiva.

Alcuni esempi applicativi

Per comprendere meglio l’importanza dell’impiego dei Big Data è bene fare qualche esempio.

Partiamo dal lato industriale, dove l’utilizzo può essere utile per avviare programmi di manutenzione predittiva, in grado di ridurre i tempi morti e risparmiare sui costi stessi di manutenzione, allungando la vita media delle loro attrezzature e ottimizzando la gestione logistica dei pezzi di ricambio.

I risparmi derivanti da una manutenzione di tipo predittivo sono notevoli. Da uno studio di Deloitte emerge che adottare una strategia di questo tipo aumenta in media la produttività del 25%, riduce i guasti del 70% e i costi di manutenzione del 25%. In particolare, secondo lo studio, il principale beneficio è rappresentato dalla riduzione dei tempi di inattività non pianificati, che a livello globale presentano un costo per i produttori industriali che può essere stimato in 50 miliardi di dollari l’anno.

Passiamo al marketing dove l’impiego dei big data fornisce opportunità incredibili. Per esempio, conoscere le esigenze e il sentiment dei clienti, individuare più velocemente il proprio target di riferimento, personalizzare la relazione con il consumatore attraverso comunicazione ad-hoc e così via. L’impiego dei Big Data è prassi consolidata nella costruzione dei “metodi di raccomandazione”, come quelli utilizzati da Netflix e Amazon per fare proposte di acquisto sulla base degli interessi di un cliente rispetto a quelli di milioni di altri. Netflix utilizza la data analytics raccogliendo dati dai suoi 151 milioni di abbonati e implementando modelli di analisi dei dati per scoprire il comportamento dei clienti e i modelli di acquisto. Poi, impiega queste informazioni per raccomandare film e programmi televisivi in base alle preferenze dei loro abbonati. Secondo la società, oltre il 75% dell’attività degli spettatori si basa su raccomandazioni personalizzate. Essa raccoglie diversi punti di dati per creare un profilo dettagliato sui suoi abbonati. Il profilo è molto più dettagliato rispetto ai personaggi creati attraverso il marketing convenzionale. I risultati sono evidenti: con una valutazione aziendale superiore ai 164 miliardi di dollari, Netflix ha superato la Disney come media company più apprezzata al mondo.

Anche il settore bancario e assicurativo trae vantaggio dall’uso dei Big Data, per esempio nell’identificazione delle frodi, grazie a cui si può far riferimento a frodi bancarie tradizionali che già molti istituti di credito tentano di combattere, ma anche a tentativi di phishing o di truffe assicurative. Visa può testimoniare come l’uso di Big Data e AI sia stato prezioso in questo campo: applicando algoritmi al numero di transazioni globali di e-commerce che elabora ogni anno, ha evidenziato che le tecnologie intelligenti hanno contribuito a ridurre le perdite basate su frodi per le istituzioni finanziarie di 25 miliardi di dollari in un solo anno.

Ma l’ambito dove i Big Data possono fornire un grande beneficio riguarda la sanità. Pensiamo all’assistenza sanitaria, che si basa sulla capacità di individuare i modelli e trasformare alti volumi di dati in conoscenze utilizzabili per la medicina di precisione e i responsabili delle decisioni. In diversi contesti, per esempio, l’impiego dei Big Data nella sanità sta già fornendo soluzioni per il miglioramento della cura dei pazienti.

Studi recenti suggeriscono che il settore sanitario potrebbe risparmiare una cifra tra i 350 e i 490 miliardi di dollari circa, applicando l’analisi dei big data ai set di dati esistenti.

Ma per avere un’idea più semplice dell’opportunità dell’impiego dei dati per la salute, basti pensare all’impatto della diffusione degli smart watch e dei fitness tracker, che sempre di più saranno in grado di monitorare in tempo reale variabili fondamentali del nostro stato di salute, agendo come dei veri e propri salvavita.